圖、文/愛范兒授權轉載

上週,AIGC 的變化讓世界變得瘋狂,每天醒來都可能是一個「新世界」。

但從另一個角度上來說,無論 AIGC 如何智慧和顛覆,我們仍然處於「舊世界」,或者準確的說,應該是「候補」世界。

不止是 New Bing,其他像是 Github Copilot X,ChatGPT 的外掛,Midjourney v5,以及 Adobe 的 Firefly,甚至是中國百度推出的文心一言,在你體驗之前,都需要加入 Waitlist 名單進行排隊等待名額。這個過程,像極了計劃經濟的配給制。

隨著 AIGC 的服務越多,也包括原有的像是 GPT-4、Midjourney V5 的升級,Waitlist 的時間彷彿被延長。

▲ Midjourney v5

直到如今,仍然有相當多人還在 New Bing 的 Waitlist 等候清單之內,更別說其他更新的生成式 AI 體驗。

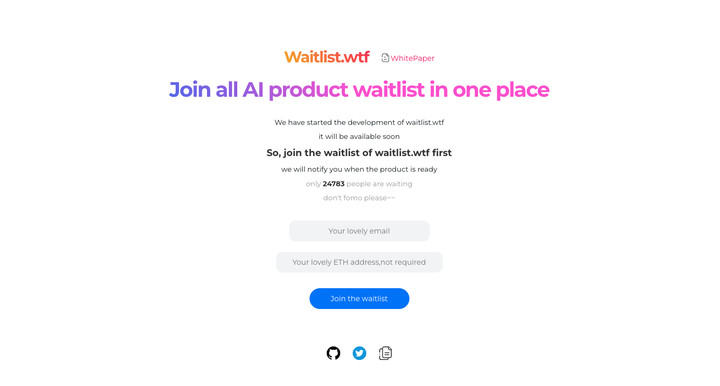

或許是對 Waitlist 等候清單這個潛規則的無聲反抗,有人做了一個「一鍵進行所有排隊」的網站。

不過諷刺的是,「一鍵加入」的功能不只還沒做好,你甚至也要先加入 Waitlist 等待,且網站域名後綴是 wtf, 整個就是怨氣爆表。

候補名單的背後是為了更穩的服務

當我把這個問題丟給 New Bing,Bing 從 OpenAI 官方網站的三個頁面裡找到了四個原因。

- 限制使用者數量,保證服務品質和穩定性。

- 收集使用者反饋,改進服務功能和體驗。

- 增加使用者期待和參與感,提高服務知名度和口碑。

- 篩選出符合目標人群的使用者,提高服務轉化率和留存率。

而這也更像是 OpenAI、微軟、Google 等大公司針對無限期 Wait 的一些官方話術。

相對來說,最先走入大眾的 ChatGPT,隨著模型的升級,以及大幅度降價,ChatGPT 的服務也出現過不少的波動。

吞過問答記錄,當過機,以及問答列表的混亂等等穩定性問題。

而基於 OpenAI 的 New Bing 同樣也出現不恰當的言詞,一直到現在,微軟持續在限制 New Bing 的對話次數與長度。

你可以說,限制使用 ChatGPT 和 New Bing 的人數,能夠提供更穩定和快速的回應和內容生成。

但要知道這些功能和服務,已經消耗了相當大的資源,幾乎佔用了微軟 Azure 一半的算力。

目前,AIGC 還尚未出現超級 App,仍然處於一個快速更迭的過程,甚至也可以說仍然是一個 Beta 測試版本。

通過傳統的對話框與 AI 進行交互,其實是與 2023 年人手一台智慧型手機的狀況有點不太搭。

AIGC 現在只能算是一個功能,而即將推出的 Copilot、Firefly 等才更像是個產品。

▲ Office 365 的 Copilot 功能

但它們仍然還未向外開放,依然躺在一個個 Waitlist 等候清單裡。

從某方面來說,微軟、Google、Adobe 還在「打磨」自己的產品;而從另一個方向來看,想要對所有人敞開大門,或者說 AI 成為每個人的 Copilot,還需要突破一些「瓶頸」。

才剛蓬勃發展的 AIGC,可能已經開始遇到瓶頸了

這裡的「瓶頸」,並非是外在表現的那些生成式 AI 所遇到的倫理、法律法規或者說其響應的準確度。

反而是 AI 背後提供算力的硬體,以及各種用於訓練的雲端計算。

微軟 Microsoft 正持續在 OpenAI 上大手筆的投入,先後投入幾十億美元,也逐步出現了基於 GPT-4 的New bing,和後續還在 Waitlist 上的新 Office。

同時,為了保證 New Bing 以及後續具有 Copilot 功能的新 Office 能夠穩定快速的響應,微軟也提供和預留了其 Azure 雲端服務的一半算力和運算容量。

如此也導致了微軟內部 Azure 算力運算資源的緊張。 The Information 就採訪了微軟內部員工,針對於有限的硬體運算資源,微軟正在實行內部硬體 Waitlist 制度。

微軟內部其他開發機器學習模型的團隊和部門,想要調用 Azure 的 AI 雲端服務,需要逐級審批報備,並最終由一位副總裁來決定。

就如同我們在排隊體驗新的生成式 AI 服務一樣,除了 New Bing 和 New Office 和 OpenAI 服務外,微軟其他部門也在等待多餘的 Azure 雲端算讀同場。

只是,隨著微軟 All in OpenAI 的策略,Azure 雲端相關算力和容量也顯得十分緊張。

除了內部借用外,Azure 也針對外部商業使用者提供了各種產品和服務,包括 AI、計算、容器、混合雲、網際網路等。

作為雲端服務供應商的 Azure 目前擴展到全球 60 多個區域,其對外服務器產品和雲服務收入占微軟總營收的 36%。

但與微軟內部團隊類似,購買 Azure 的客戶也受到了算力受限的影響,尤其是想要調用 Azure OpenAI 依舊需要加入 Waitlist。

大概從 2022 年底,微軟就打算增加更多的硬體(GPU 或者 TPU)來擴充更多的算力。

不過,目前微軟與 Nvidia 並未透露在 Azure 當中 H100 的分配情況,微軟內部也只有一小部分團隊擁有 H100 的使用權限(大概是用在 New Bing 和 Office Copilot 上),大部分的部門仍然被排除在外。

一顆 H100 大概的售價可能在 24 萬元上下,以此為參考的話,微軟為 Azure 擴充容量則需要投入數億資金。

不止是微軟,Google、甲骨文這些雲服務商,也在大力投入 GPU 等硬體為自己的雲端服務擴充容量,準備在 AIGC 徹底爆發之前,做好算力上的準備。

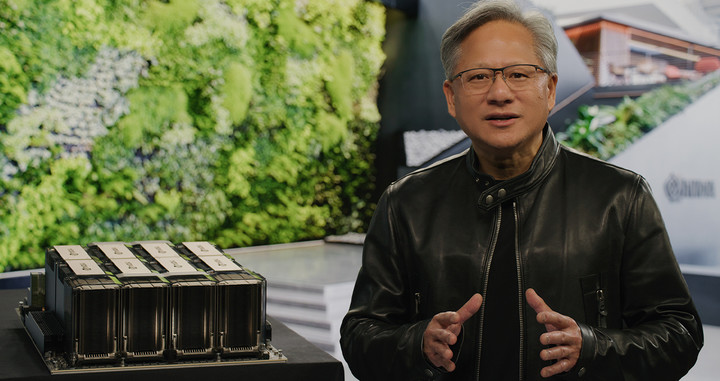

▲ Nvidia CEO 黃仁勳與 OpenAI 聯合創辦人兼首席科學家 Ilya Sutskever

但從 GTC 2022 發佈到現在,Nvidia 並沒有對外公佈 H100 的供應和銷售情況,微軟對於 Azure 的容量擴充計劃是否有效也不得而知。

而在今年的 GTC 2023 中,Nvidia 並沒有帶來關於 H100、A100 硬體上的進展,而是一直在強調 Nvidia 在雲端運算硬體上的優勢。

Nvidia 首席技術官也開始強調,「加密貨幣對於社會沒有任何有益的貢獻」,也從側面開始強調 AIGC 領域將會是 Nvidia 接下來 30 多年所專注的領域。

隨著 AIGC 領域的持續更新,大概從 2022 年 10 月份,Nvidia 的股票也隨之增長,一掃此前因為加密貨幣衰退而導致的業務下滑頹勢。

目前,Nvidia 的市值又達到了一個高點,幾乎等同於 Intel、AMD、ARM 這三家市值之總和。

但如此的高市值,似乎並沒有改善硬體的供應狀況,反而隨著 Google、微軟等大企業不計成本資源地對雲端運算硬體投入,按照此前 Nvidia 的供應狀況,很可能再次出現工業顯卡荒的一個局面。

不只是硬體供應狀況,這些高性能 GPU 組成的運算陣列也有著很高的功率,單張 SXM 的 H100 運算卡功率就達到了 700W。

用於 AI 模型訓練和大數據處理的運算中心的耗電量實際上也十分驚人。

在 2021 年,加州大學的 David Patterson、Joseph Gonzalez 通過研究表明,訓練 GPT-3 大概需要耗費 1.287 千兆瓦時的電力,它相當於 120 個美國家庭一年的用電量。

同時,這篇論文還發現,訓練 GPT-3 會產生 502 噸的碳排放,等同於 110 輛汽車的一年排放量。

他們也強調這只是一個模型的訓練成本,隨著它湧入市場,也會產生更多的資源消耗,可能要比訓練成本還高。

OpenAI 的 GPT-3 可以使用 1750 億個參數或者變量,而 GPT-4 的參數預計在 1750 億到 2800 億之間。對於能耗,雲端計算的需求只增不減。

為此,OpenAI CEO Sam Altman 在接受 The Verge 採訪時表示,OpenAI 正在尋找有效的方法來提升模型的性能和安全性。

換句話說,OpenAI 也在試圖通過更高效的算法來尋找節省訓練運行模型的硬體需求與電力資源。

Waitlist 的機制,從淺層來看,它確保了當前 AIGC 的使用體驗,以及相關服務的回應速度。

但從深層次來看,它也是一場資源角力,是 GPU、TPU 為核心的雲端運算中心算力和容量的互相角力,也是宏觀上高投入高能耗的一場競爭。

而到目前為止,AIGC 其實仍處於一個「盲盒」階段,對於資源的需求和占用也尚不明朗。

不過,站在各種 AI 服務的 Waitlist 排隊名單裡,確實很像在科幻電影裡,人們正不斷排隊進入 AI 控制的工廠,為其運作提供所需的資源。

Waitlist,即是虛擬世界裡的候補名單,也可能是將來現實世界當中的一則為 AI 服務的隊伍。