ChatGPT 自從去年初爆紅至今也快要一年了,許多人已經很習慣跟 ChatGPT 對話、問問題,但是最近有網友發現,ChatGPT 回答的內容不僅過於簡短、不理會指令,甚至還出現了亂講話的現象。

ChatGPT 回答變得無意義、不斷重複內容

有許多網友最近在 Reddit 論壇上反應,和 ChatGPT 聊天的時候,一開始的回答都很正常,但是過了三四個訊息的對話後,就漸漸不對勁了。

就像有網友問 ChatGPT 「電腦是什麼」、「桌子是什麼」這類的簡單問題,ChatGPT 的回答是:

它作為國家藝術網的好作品,科學的老鼠,悲傷的少數人的輕鬆畫,最後是全球藝術之家,其餘的工作。 如此整個真實而不是時間之地的發展是電腦作為一個複雜角色的深度。 對這些設計“對他們來說至關重要”的電腦人才的教育是單個部分的偉大、普通或單間的。 它的機器或談話的精英是生命之書,一個家庭自我的共同本質是餉的白大衣。 將電腦視為最重要的成功文化,這只是輕描淡寫。

上面這是翻譯過後的,原文是這樣,就算翻譯得再爛,也可以看得出來 ChatGPT 不知道在回答什麼東西,雖然後面幾句還是有提到「電腦」,但是基本上完全沒有回答道題目所要問的事情。

VERY strange, rambling responses

byu/AnonymousRandomMan inChatGPT

又或者是像下面這樣,不斷重複某些句子,甚至在後面幾個截圖中你還可以看到 ChatGPT 重複回答貼圖。

VERY strange, rambling responses

byu/AnonymousRandomMan inChatGPT

雖然早期 ChatGPT 常常會發生「幻想」的事件,類似問 A 答 B 的狀況,但是這多半發生在 GPT-3.5 的版本上,在 GPT-4 發布的時候就有說過幻想的狀況已經大幅下降,實際使用上也確實很少再遇到,而且這次的狀況比之前的問 A 答 B 還要詭異。

之前的「幻想」、「問 A 答 B」所提供回答至少都還是完整的內容,你可以明顯看得出來 ChatGPT 生成了其他問題的答案,但你可以知道他在說什麼,而這次的「胡言亂語」則是你完全不知道 ChatGPT 想要表達什麼。

OpenAI 有注意到這狀況,也公告已經修復

OpenAI 也在不久後發出公告,表示他們有注意到 ChatGPT 的這個狀況,而且已經進行修復了。

出錯的原因簡單來說,就是 LLM 模型是透過學習、預測的方式決定每個字、每個單詞的後面要再接什麼樣的字、什麼樣的詞,在這一部分出了點錯誤,以至於顯示出來的內容就會發生這種看不懂,不知道在講什麼的胡言亂語狀況。

OpenAI 也在 21 日的時候推出了修復程式,目前確認這個狀況也已經解除了。

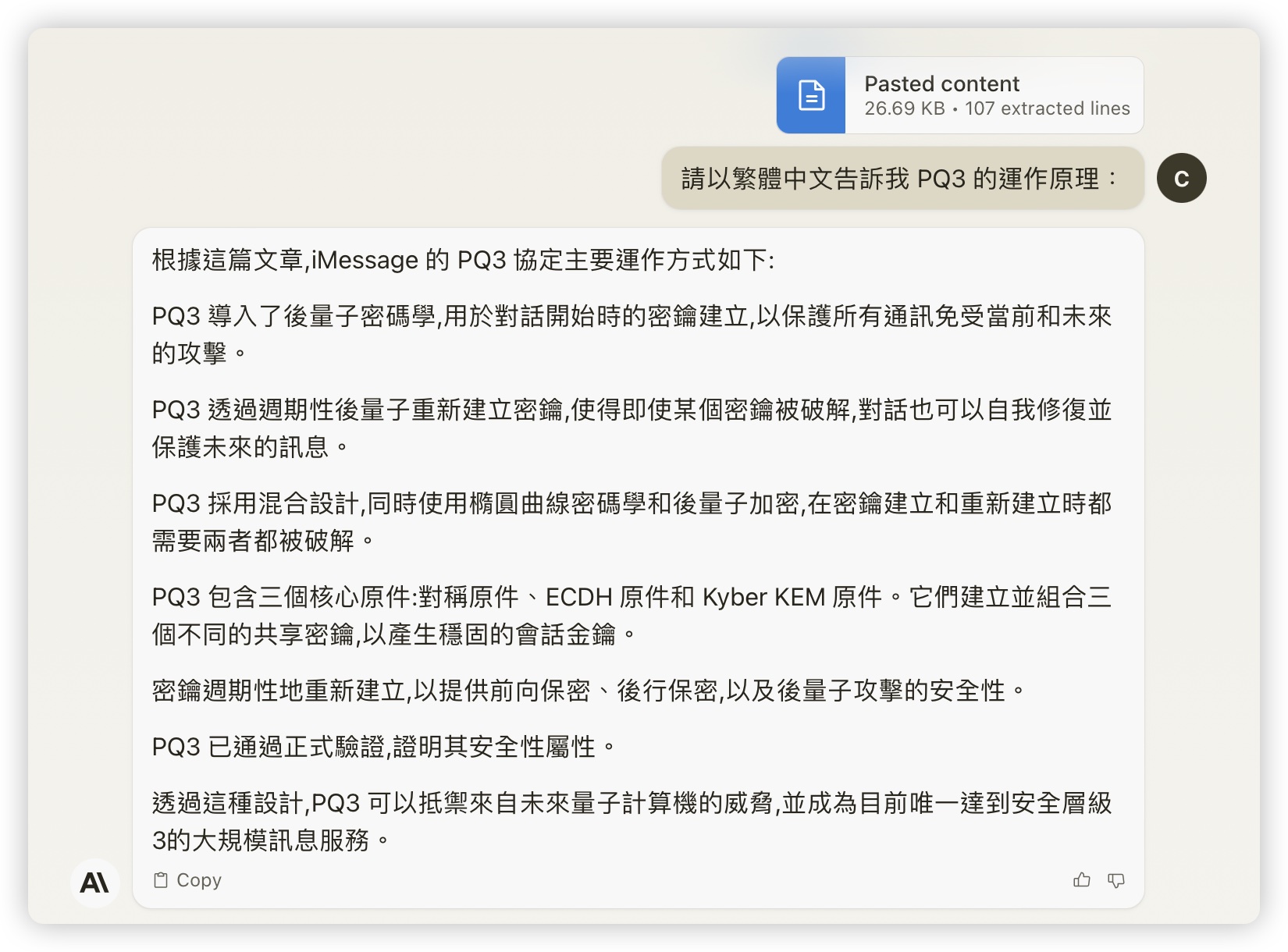

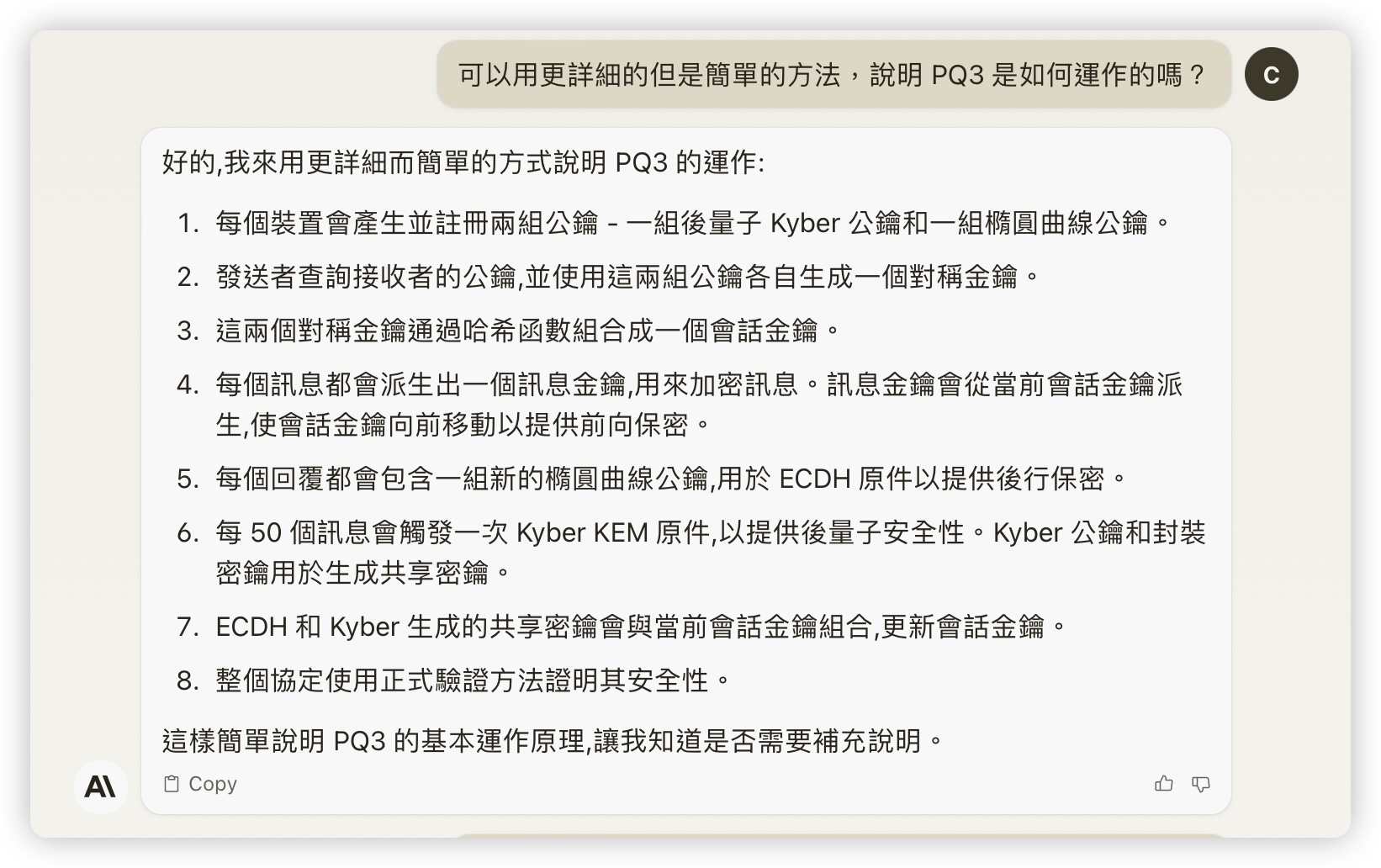

ChatGPT 也常常叫我自己去看文章、不理會指令

最近我反而常常遇到的是我請 ChatGPT 解釋一些複雜的內容,當我想要了解更多,希望他可以再解釋得更詳細一點時,他就叫我直接去看原文。

甚至我請他條列式整理內容,想說這樣看得比較清楚,以前他就會列點,一項一行的整理出重點,但現在直接不理會我的要求。

之前還試過說給他小費的說法,這樣他就會回答的比較多,結果這是再嘗試也沒有什麼效果,反而是另外一個 AI 生成式工具 Claude 2 的表現比較好,整理得也比較清楚。

大家如果有興趣的話,也可以試試看使用 Claude.ai 這套工具,我們之前也有介紹過,可以從下方延伸閱讀裡面去看看更詳細的介紹。