前一陣子蘋果推出的新兒童安全政策,為了保護兒童安全與阻止兒童性虐待素材 CSAM(Child Sexual Abuse Material)傳播,新功能會檢查儲存在 iCloud 中的照片,若有 CSAM 相關的照片存在 iCloud 中,會自動與相關執法單位。但外媒 9to5Mac 報導表示,蘋果向他們承認,早在 2019 年就開始執行相關的掃描作業。

蘋果早在 2019 年就開始掃描 iCloud 郵件

近日蘋果向外媒 9to5Mac 承認,蘋果自 2019 年,就已經開始掃描 iCloud 郵件,檢查兒童性虐待素材 CSAM(Child Sexual Abuse Material),但是並沒有掃描 iCloud 照片與 iCloud 備份。

因為電子郵件沒有加密,所以掃描郵件這件事對於蘋果來說是一件非常容易的事。蘋果也表示,目前也正在進行一些線上有限掃描,但是沒有明說是掃瞄哪些東西,只是稍微暗示是小規模掃描。但確定不包含 iCould 備份。

蘋果執行 CSAM 掃描的原因

蘋果在兒童安全說明頁面內文(節錄):

無論產品在哪使用,蘋果都致力於保護整個生態系統中的兒童,我們將繼續在該領域繼續創新。

作為承諾的一部分,蘋果使用圖像匹配技術來幫助檢查與通報兒童虐待案件,就像電子郵件中的過濾器一樣,我們的系統使用電子簽名檔來檢查涉嫌兒童虐待的行為。透過單獨審核來驗證,含有虐待兒童相關內容的帳戶違反了我們的服務條款,我們發現後都會將這樣的帳戶禁用。

另外兩種新兒童安全功能

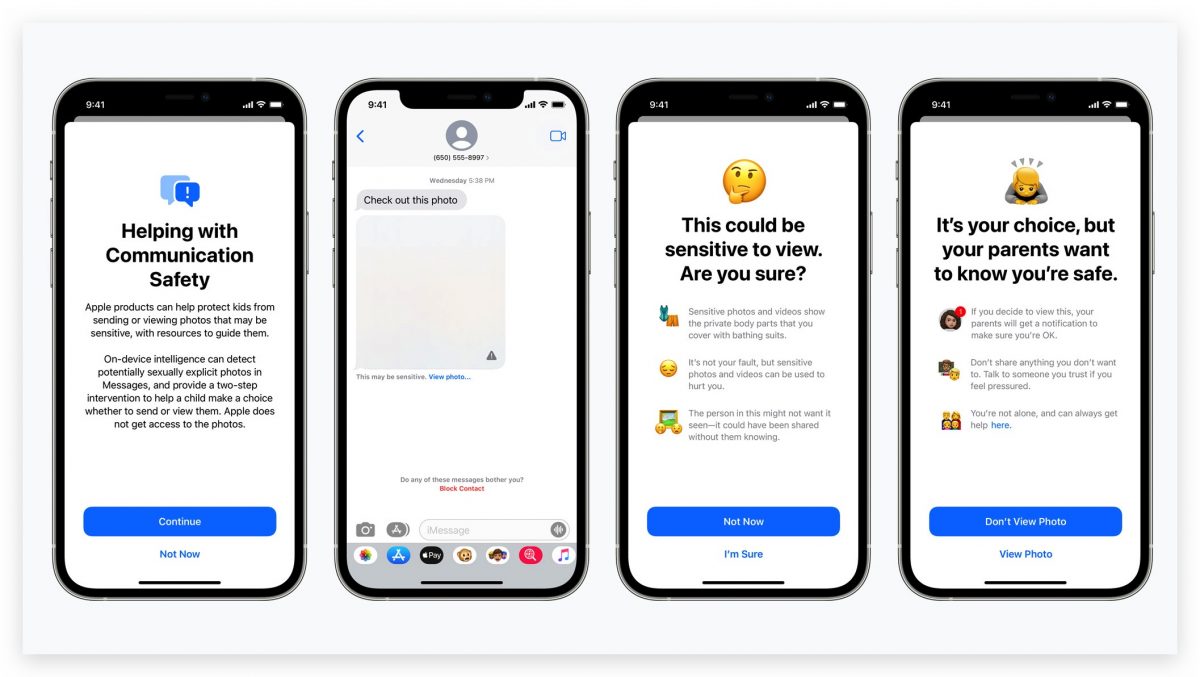

除了檢測上傳至 iCloud 的兒童色情照片外,蘋果也發表了另外 2 項兒童安全功能:訊息 App 會阻擋敏感圖片、搜尋敏感內容時會發出警告。

訊息 App 會阻擋敏感圖片

收到敏感內容的照片時,照片會自動模糊,兒童不會看到相關的敏感內容。同時為了確保孩童安全,在收到或是發送內含敏感內容的訊息時,孩童與家長都會收到警告訊息,即時阻止敏感訊息傳播。

搜尋敏感內容時會發出警告

若使用 Siri、Spotlight 搜尋 CSAM、相關兒童色情內容時,新功能也會阻擋,並發出警告訊息。 Siri、Spotlight 的警告功能,將在今年稍晚更新至 iOS 15、iPadOS 15、watchOS 8、macOS 12 Monterey 中。

延伸閱讀》

- 用 iPhone 傳色情照片將被自動打馬賽克,還會檢查 iCloud 內的兒童色情照片

- iPhone 的模糊色情照片功能,只有孩童用戶可用,成人用戶不受影響

- iCloud+ 推出:隱藏郵件、加密網路瀏覽、增加利用聯絡人取回密碼功能